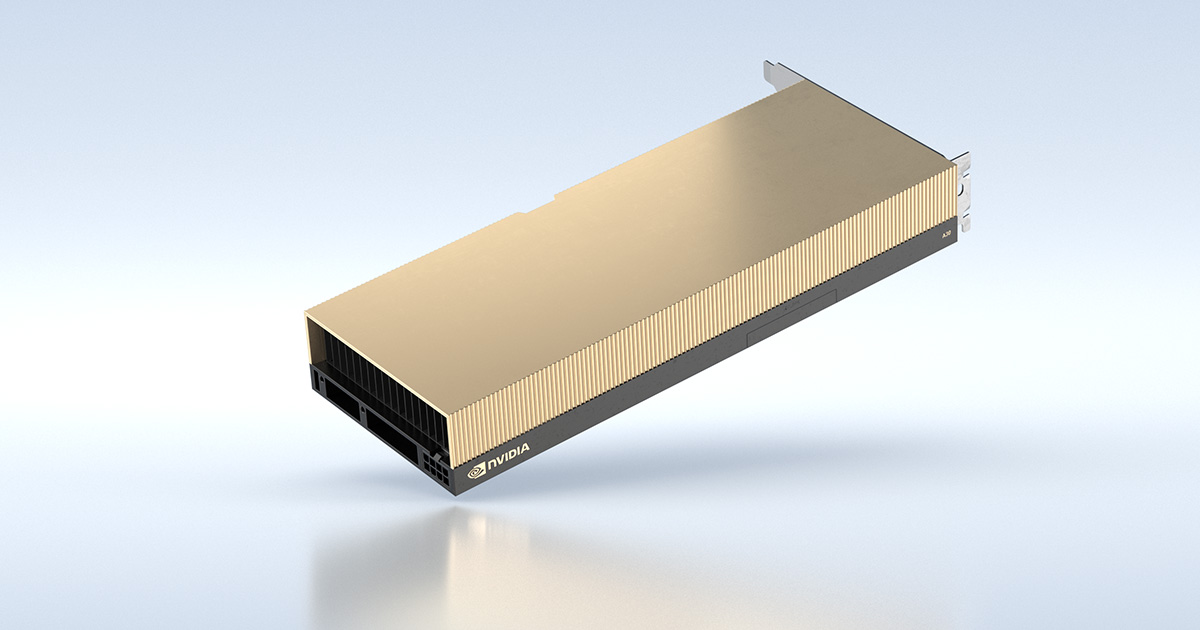

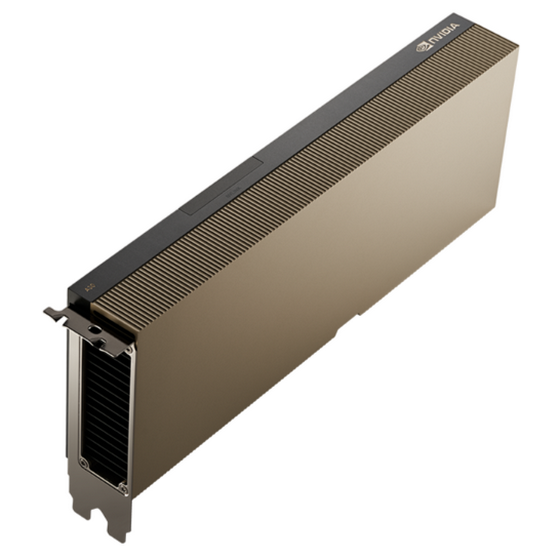

NVIDIA A30

Procesor graficzny NVIDIA A30 z rdzeniami tensorowymi zapewnia wszechstronną platformę dla głównych zadań korporacyjnych, takich jak wnioskowanie AI, szkolenie modeli sieci neuronowych i HPC. Dzięki obsłudze TF32 i FP64 z wykorzystaniem rdzeni tensorowych, a także kompleksowemu stosowi programowemu, A30 zapewnia, że można szybko wdrożyć podstawowe szkolenia AI i aplikacje HPC. Separowane instancje (MIG) zapewniają jakość usług (QoS) dzięki bezpiecznym, partycjonowanym sprzętowo procesorom GPU o odpowiedniej wielkości we wszystkich obciążeniach dla różnych użytkowników, optymalnie wykorzystując zasoby obliczeniowe GPU.

Trening głębokiego uczenia

A30 wykorzystuje funkcje do optymalizacji wnioskowania. Akceleruje pełen zakres formatów precyzji, od FP64 do TF32 i INT4. A30 umożliwia jednoczesne działanie kilku sieci na bezpiecznych partycjach sprzętowych z gwarantowaną jakością usług (QoS). Obsługa rzadkich macierzy jeszcze podwaja wydajność wnioskowania. W połączeniu z serwerem wnioskowania NVIDIA Triton, który pomaga w łatwym wdrożeniu sztucznej inteligencji na dużą skalę, A30 zapewnia przełomową wydajność każdemu przedsiębiorstwu.

Gotowa do użycia w przedsiębiorstwie

A30 z MIG maksymalizuje wykorzystanie infrastruktury obliczeniowej przez GPU. Dzięki funkckji MIG procesor graficzny A30 można podzielić na cztery niezależne instancje, co daje wielu użytkownikom dostęp do akceleracji GPU. MIG współpracuje z platformą Kubernetes, kontenerami i wirtualizacją serwerów opartą na hyperwizorze. MIG pozwala administratorom infrastruktury oferować GPU odpowiedniej wielkości z gwarantowaną QoS dla każdego zadania, rozszerzając zasięg akcelerowanych zasobów obliczeniowych dla każdego użytkownika.

Analityka danych o wysokiej wydajności

Analitycy danych muszą być w stanie analizować, wizualizować i przekształcać ogromne zbiory danych w szczegółowe informacje. Jednak rozwiązania skalowalne w poziomie są często blokowane przez zbiory danych rozproszone na wielu serwerach. Serwery z procesorem A30 zapewniają wymaganą moc obliczeniową, a wraz z dużą pamięcią HBM2, przepustowością pamięci 933 GB/s i skalowalnością dzieki NVLink, radzą sobie z tymi obciążeniami. W połączeniu z NVIDIA InfiniBand, NVIDIA Magnum IO i witryną RAPIDS z bibliotekami open source, w tym akceleratorem RAPIDS dla Apache Spark, platforma centrum danych NVIDIA przyspiesza te ogromne obciążenia na niespotykanym dotąd poziomie wydajności i efektywności.

|

Cechy GPU | NVIDIA A30 |

|---|---|---|

| Liczba rdzeni CUDA | 3804 | |

| Liczba rdzeni tensorowych | 224 | |

| Liczba rdzeni RT | – | |

| Pamięć GPU | 24 GB HBM2 z korekcją błędów (ECC) | |

| Interfejs pamięci | 3072-bitowy | |

| Przepustowość pamięci | 933 GB/s | |

| Wyjścia na wyświetlacze | – | |

| Maks. pobór mocy | 165 W | |

| Szyna grafiki | PCIe Gen 4.0 | 64 GB/s | |

| Form Factor | 111,2 mm H x 268,6 mm L, dual slot | |

| Chłodzenie | Pasywne | |

| NVLink | 2-drożny mostek o niskim profilu (na 2 lub 3 sloty) łączący 2 karty A30, transfer do 200 GB/s | |

| Wspierane oprogramowanie vGPU | NVIDIA Virtual Compute Server | |

| Wspierane profile vGPU | 1 GB, 2 GB, 3 GB, 4 GB, 6 GB, 8 GB, 12 GB, 16 GB, 24 GB | |

| VR Ready | Nie |

SKU: TCSA30M-PB

EAN: 3536403384135

Zawartość:

- Karta NVIDIA A30 PCIe

- Adapter zasilania 2×8-pin na 1×8-pin

- Opakowanie firmowe z logo NVIDIA